안녕하세요 💌시골 도토리입니다.💌 전 포스팅에는 rss 와 사이트 맵을 등록하는 법을 알려드렸었는데요 이번에 알려 드릴 것은 웹페이지 수집과 robots.txt입니다. 역시나 마찬가지로 웹페이지 수집과 robots.txt에 대하여 간단하게 설명을 드리자면 웹페이지 수집은 자신이 원하는 웹 페이지를 수동으로 제출하여 수집할 수 있게 하여 검색이 되게끔 하는 것이 웹 페이지 수집 요청입니다. robots.txt은 사이트마다 고유한 검색 로봇이 검색내용을 수집 할 때 자신이 원하는 사이트 역시 수집해도 된다는 일종의 동의입니다. 그럼 지금부터 웹페이지 수집 요청과 로봇에 대해 설정하는 법을 알려 드리겠습니다😄😄😄😄

역시나 바쁘신분들을 위해 밑에 간단히 요약해 놓겠습니다.

😘😘😘😘

(저번포스팅과 일치하는 부분 간략하게 요약)

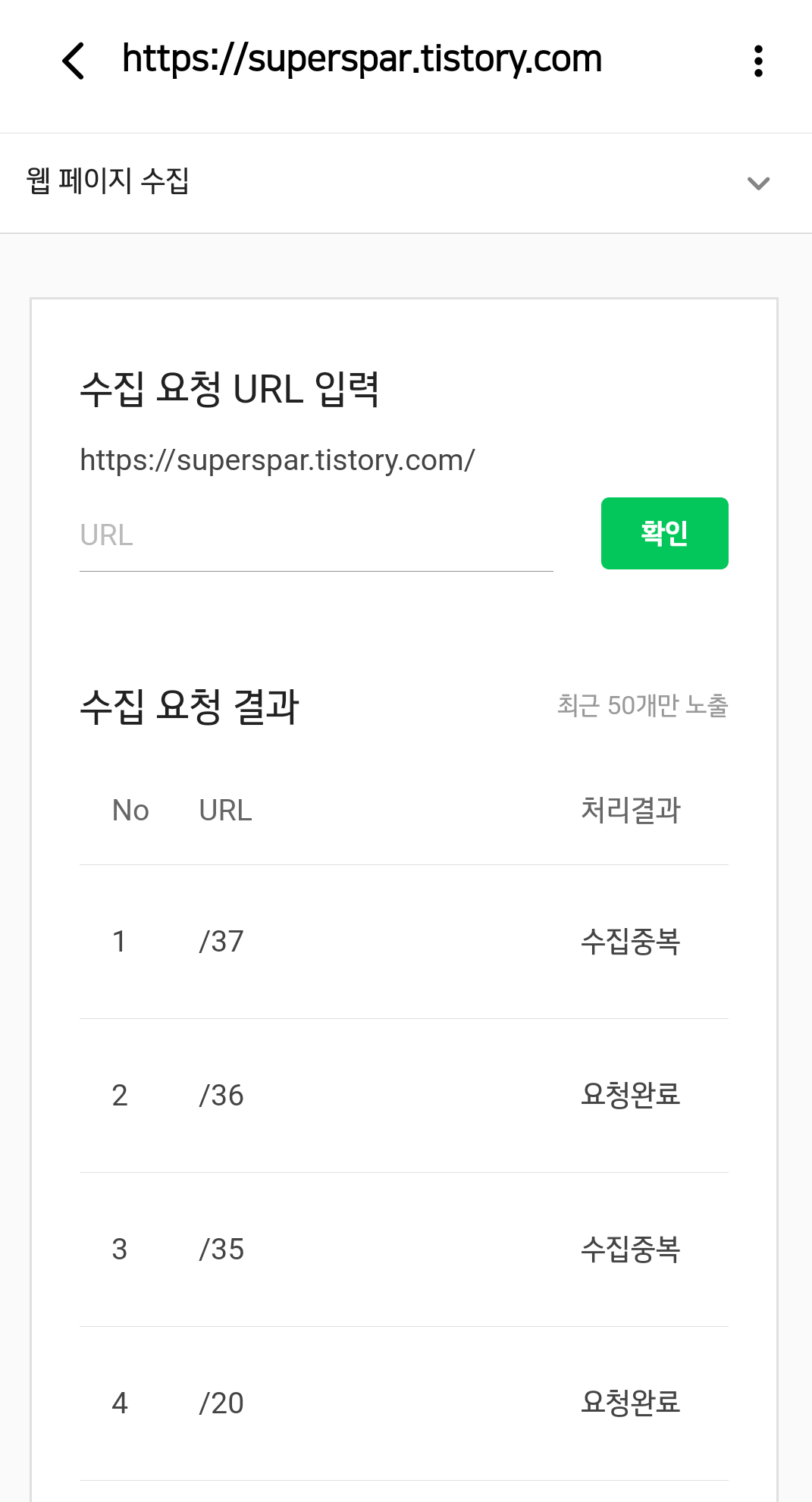

1.웹페이지 수집

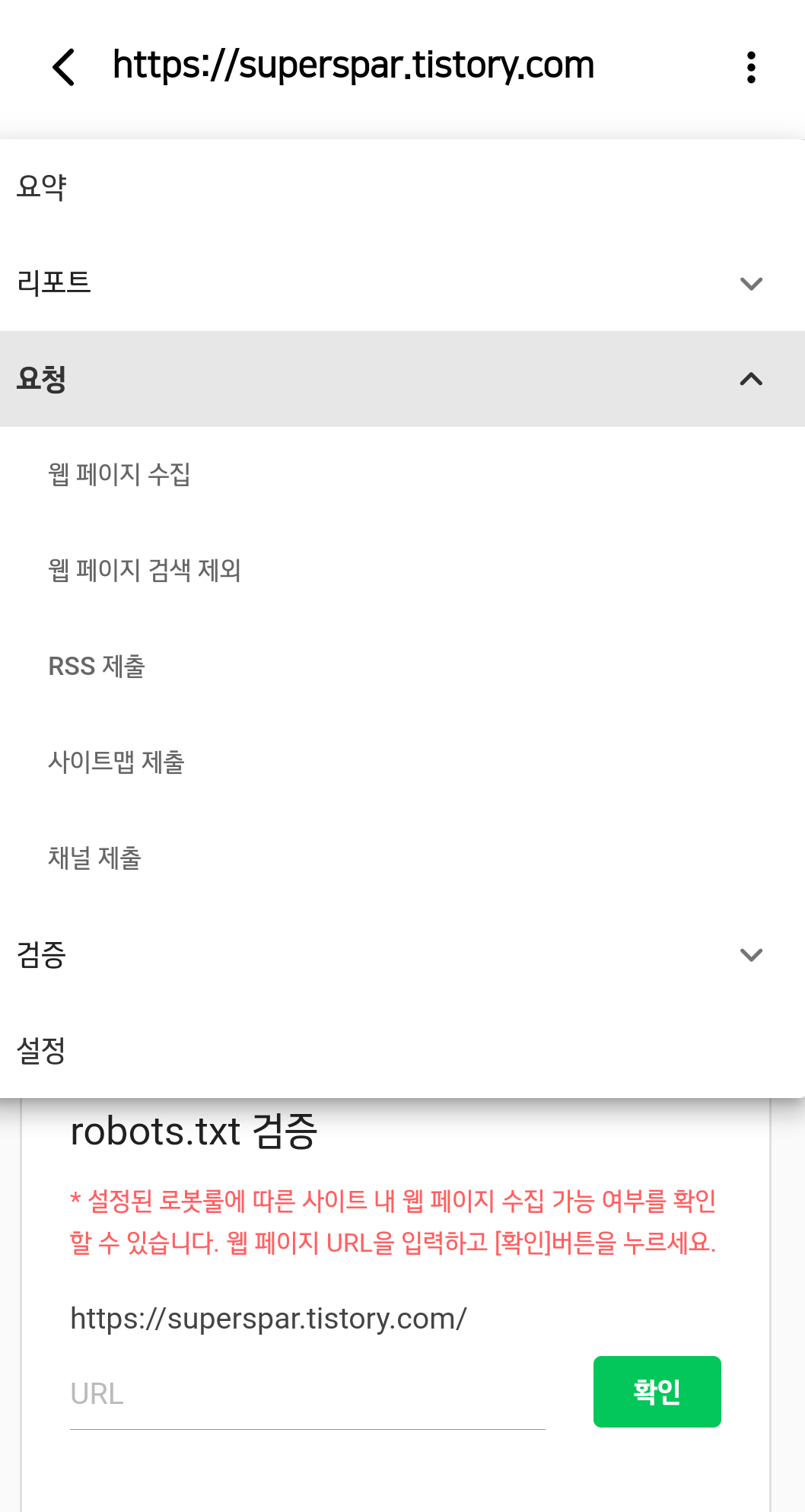

(네이버서치어드바이저-웹마스터도구 시작하기-자신이 등록한 사이트 클릭-요약클릭)

저번과 같이 사이트맵 제출하는과정을 따라하시면 웹페이지 수집이 나옵니다.

그리고 수집하고자하는 /이하주소를 적어주시면 됩니다.

저같은 경우 계속 수집보류가 떠서 몇번이고 시도해본결과 게시글중 몇개는 아직 요청완료지만 나머지는 수집이 되었습니다. 그래서 그런지 티스토리 블로그에 꽤나 많은 방문자가 생겼습니다. 이 글을 읽으시는 분들도 꼭 수집이 성공되었는지 확인해보시기 바랍니다.

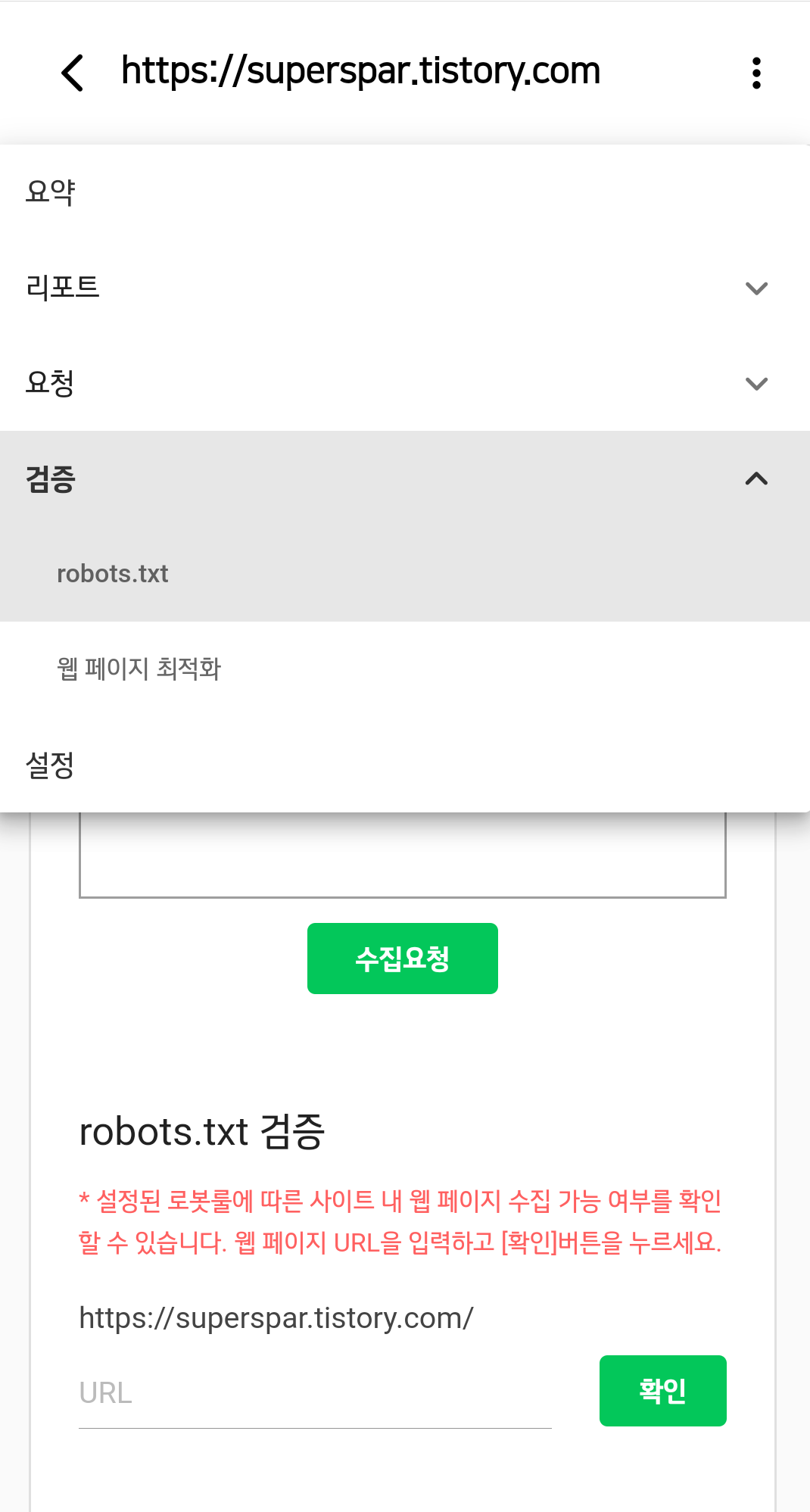

다음은 robots.txt입니다.

이번엔 요청이 아니라 검증을 누릅니다.

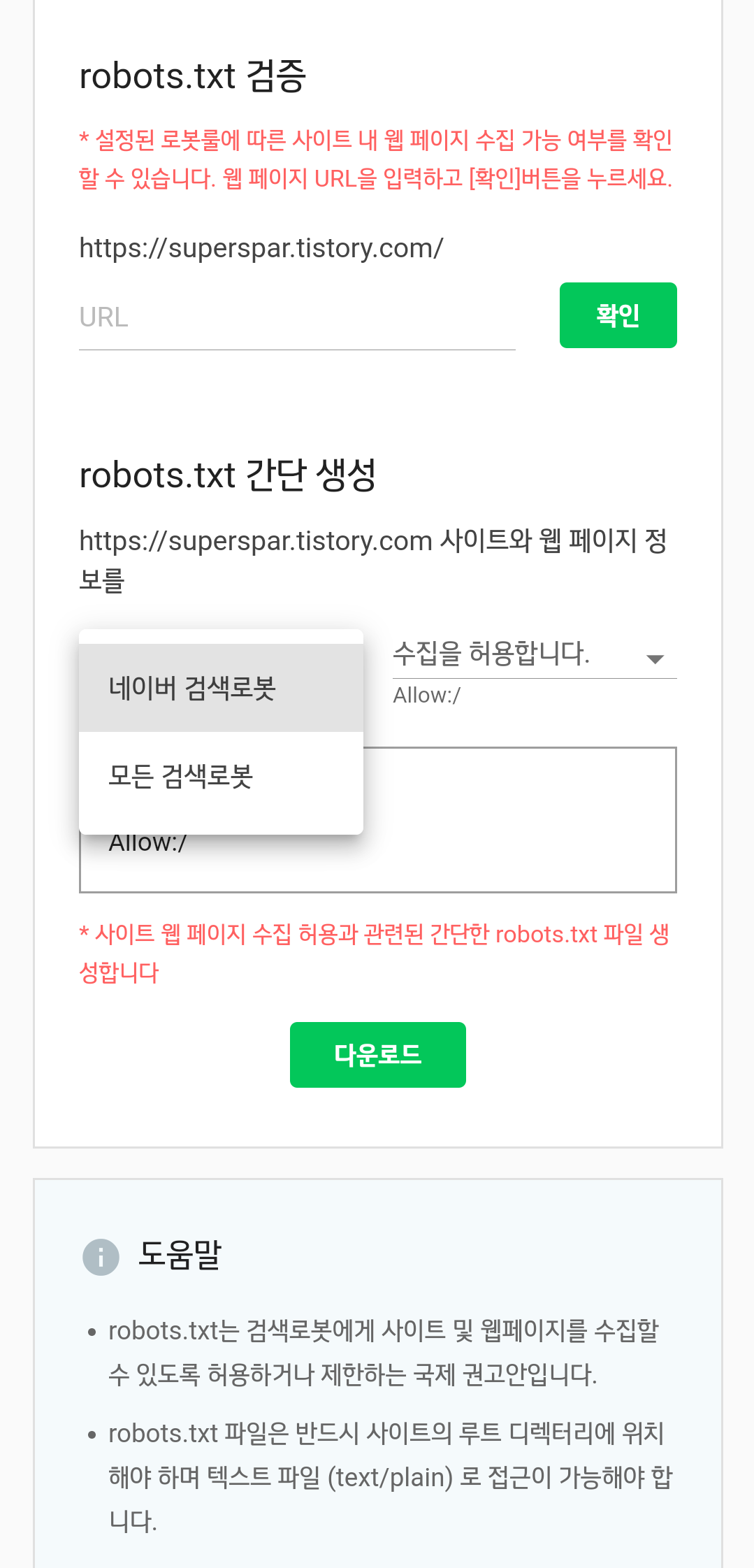

그리고 본인이 원하는 기준에 맞추어 검색로봇을 설정하고 검색로봇 파일을 찾기쉬운곳에 저장합니다.

티스토리 블로그에서 관리자 설정에 들어가 스킨 편집을 누릅니다.

여러가지 누르는게 보이지만 저번과 마찬가지로 html편집을 누릅니다.

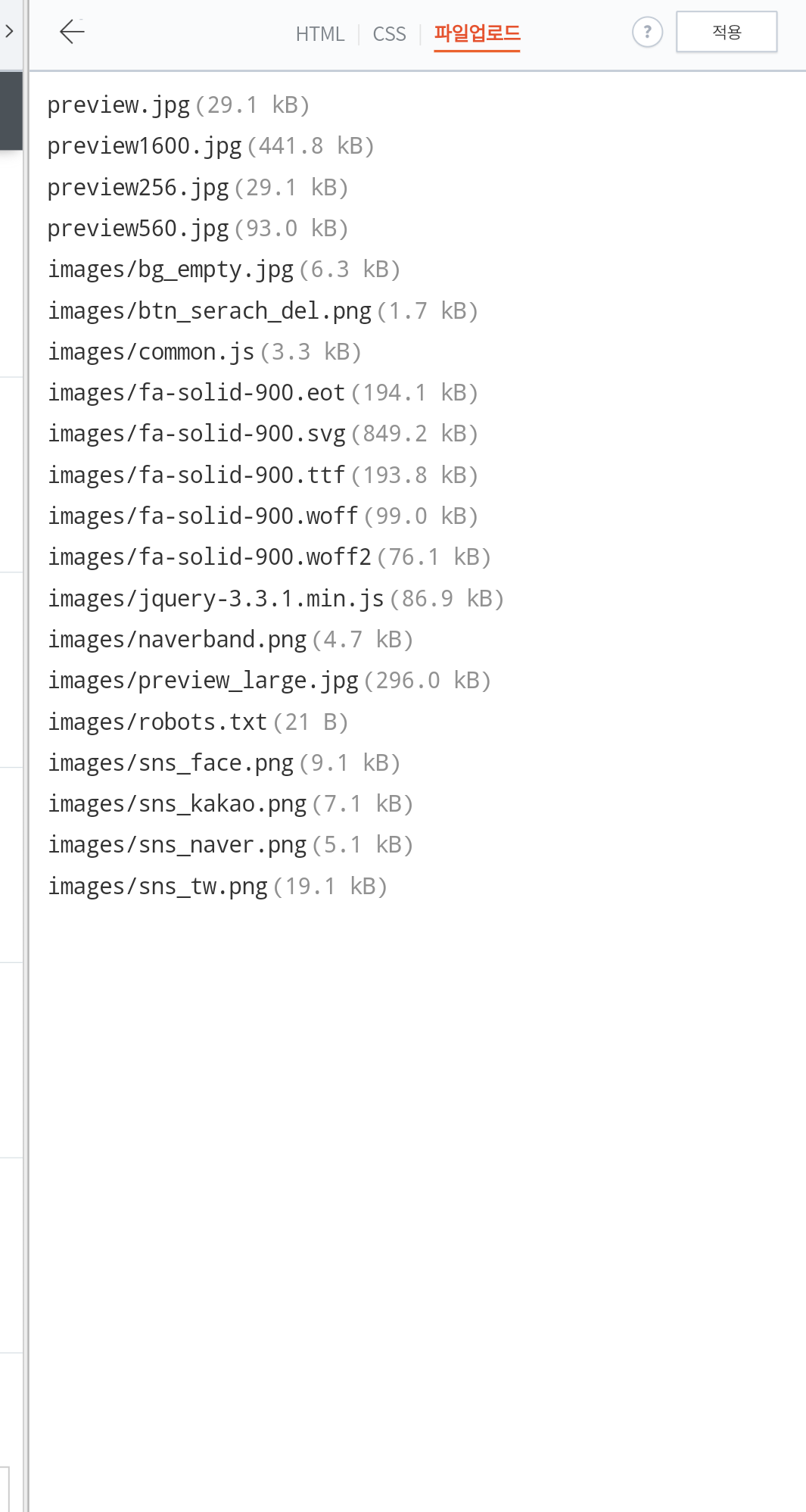

그런 뒤 htm,l css, 파일업로드중 파일업로드를 눌러 아까 저장했던 로봇파일을 업로드시키면 되는것입니다.

저는 밑에서 5번째에보시면 로봇파일이 업로드되어있습니다.👍👍👍

웹페이지수집

(요청-웹페이지수집-사이트등록 후 수집성공이 뜨면 끝)

robot.txt

(검증-robots.txt-기호에맞는 로봇생성-잘보이는 곳에 로봇파일 다운로드-티스토리블로그 관리자모드-스킨 편집-html편집-파일업로드-로봇파일 업로드가 되면 끝)

💌💌💌💌💌💌💌💌💌💌💌💌💌💌

오늘은 이렇게 해서 로봇생성과 웹페이지 수집에 대해서 해봤습니다! 다소 어렵게 느껴지실순 있지만 알고보면 참 쉽습니다! 시간이 되실때 블로그를 등록해 놓으시는건 어떨까요? 감사합니다 🌰시골도토리였습니다🌰!

구독과 댓글 남겨주시면 감사하겠습니다!

최근댓글